и чё, понимает как “воды по колено, а рыбы до хрена” ???

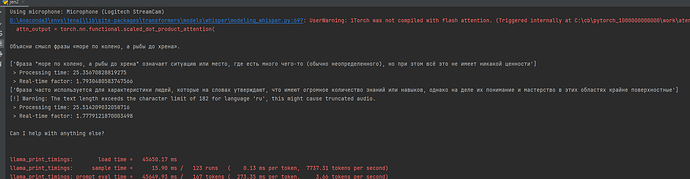

Whisper и не должен понимать, это STT моделька - переводить речь в текст, с чем он и справляется с русским языком из коробки. “Пониманием” занимается другая моделька, у меня там включена довольно слабая, поэтому налажала.

О, он подфайнтюнил модельку 15-летней давности, прикольно. Говорит, что превосходит whisper large, но сравнивает почему-то с медиумом на своём гитхабе. Ну молодец, но я пишу две строки кода, типа import whisper/large, go, и получаю в целом результат не хуже, чем у него, только затратив две секунды, а, ну и ещё лекций я не читаю. Но пусть хоть так, тоже неплохо, да.

Тут поднимается опять древний философский вопрос насчёт “сделано у нас”. Ну вот ардуина, придумана в италии, изготовлена в китае, прошивку написали мы здесь - можно ли считать, что устройство “сделано у нас”? И да, и нет. Ну вот и тут примерно то же ))

У одной семиклассницы спросили как звали гитлера, она ответила, что его звали капут.

я дико извиняюсь… ![]()

Мы с начальником в НИИ

Проектируем ИИ

А уже потом ИИ

Проектирует хуи

А как вам такая новость, благородные доны?

Как то все это тревожно. GPT4o только с третьего прохода научился освобождать память после new у мня.

ну, это дискуссионный вопрос. Поскольку в природе не существует сколько-нибудь внятного определения ИИ, можно бесконечно спорить, где он есть, а где - нет.

Критерий Тьюринга - не?

Или затык на определении “искусственный”?

Да, просто нет общепринятого определения. Вообще, это не научный термин, а журналистский.

Некоторые считают, что chatgpt тест Тьюринга уже прошёл. А так-то это всё пока что нейросеть, средняя статистика.